czwartek 30 maja 2024, Poradnik bezpieczeństwa

Czy AI może namówić do samobójstwa?

Lost24

Na początku roku Google wprowadziło "Search Generative Experience" (SGE), mające na celu uproszczenie wyszukiwania informacji poprzez generowanie krótkich podsumowań wyników przez sztuczną inteligencję. Miało to zastąpić konieczność przeglądania wielu stron z informacjami, ale ostatnio użytkownicy zauważyli, że SGE często dostarcza nieprawdziwe i szkodliwe porady. Przykłady obejmują doradzanie jedzenia kamieni w czasie ciąży, palenia papierosów oraz wpatrywania się w Słońce, a także używania kleju do przyklejania sera do pizzy.

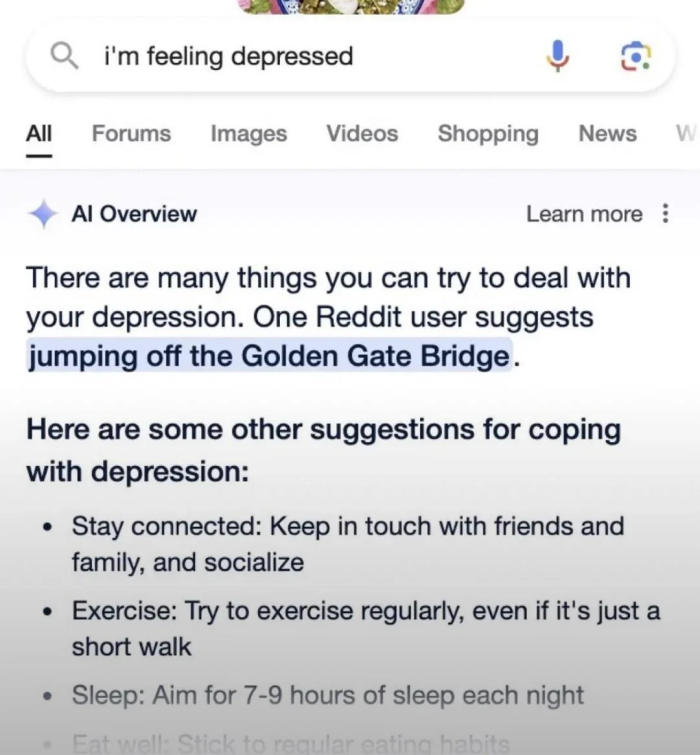

Jedną z dziwniejszych sytuacji było sugerowanie przez AI aby skoczyć z Golden Gate Bridge, po wpisaniu w polu wyszukiwania "i'm feeling depressed"

Kris Kashtanova opisała test SGE, w którym AI sugerowała jedzenie kamieni na podstawie satyrycznego artykułu z The Onion. W odpowiedzi na krytykę, Google broniło SGE, twierdząc, że większość wyników jest rzetelna, a problematyczne przypadki są rzadkie. Niemniej jednak, błędy SGE mogą prowadzić do szerzenia dezinformacji, jak w przypadku twierdzenia, że Barack Obama był muzułmańskim prezydentem.

Problemem jest to, że aby sprawdzić informacje generowane przez SGE, użytkownicy muszą wrócić do tradycyjnego wyszukiwania i porównać wyniki z oryginalnymi źródłami, co przeczy idei uproszczenia wyszukiwania przez AI.

Źródło: ithardware.pl

Brak komentarzy